课题组研究方向主要分为:

1.具身智能(VLN、VLA)

2.大语言模型(人机对话导航等)

3.计算机视觉(医学影像处理)

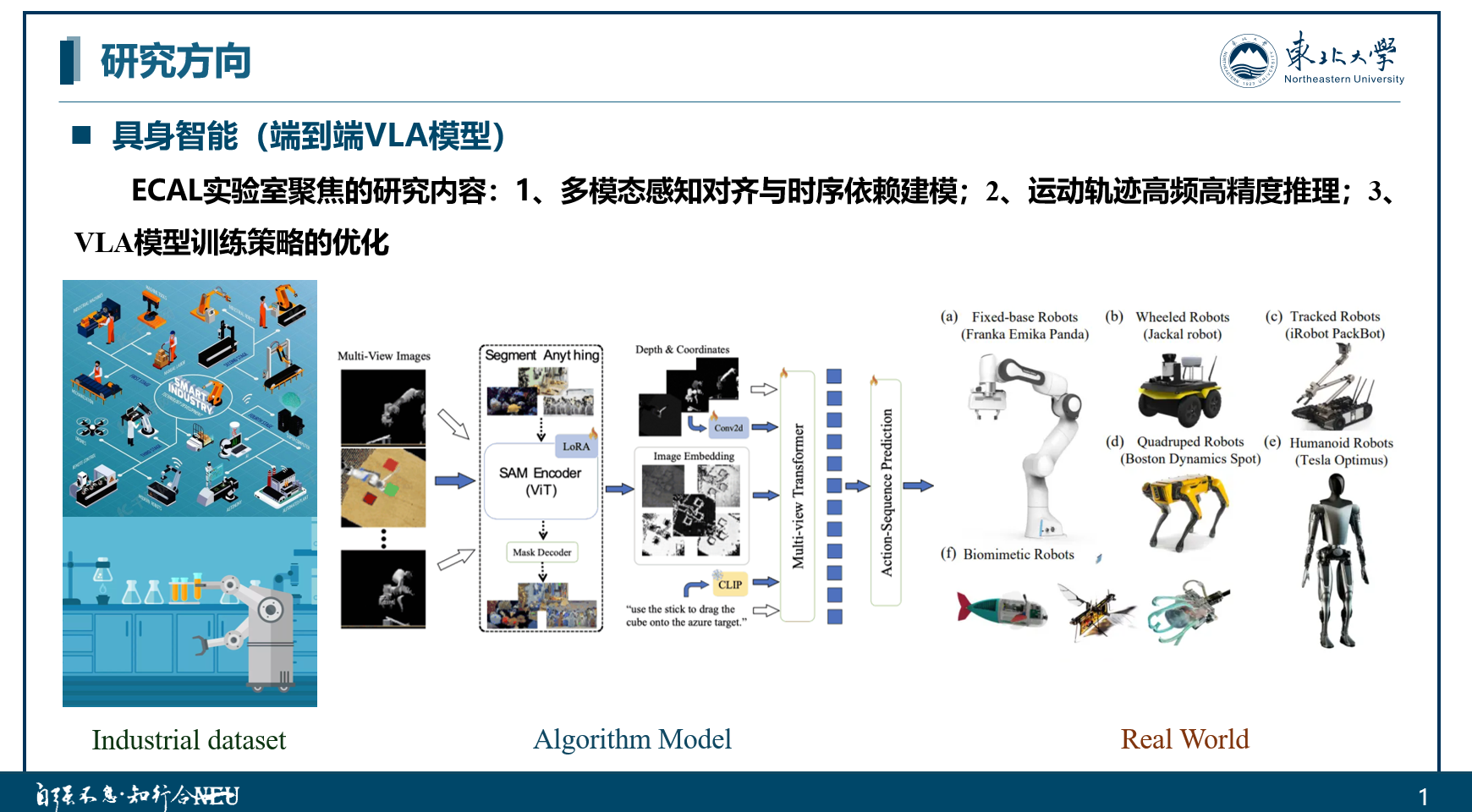

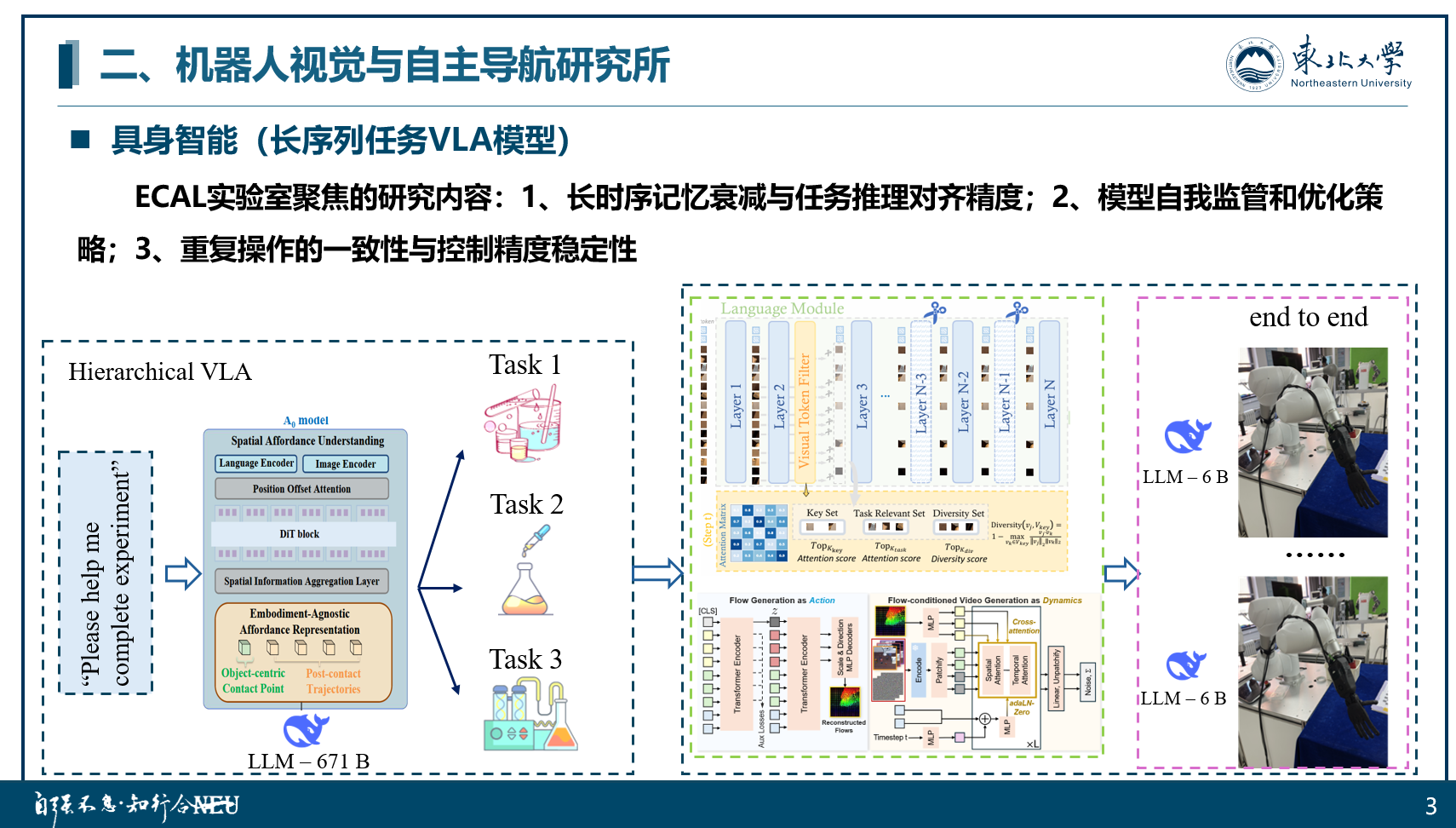

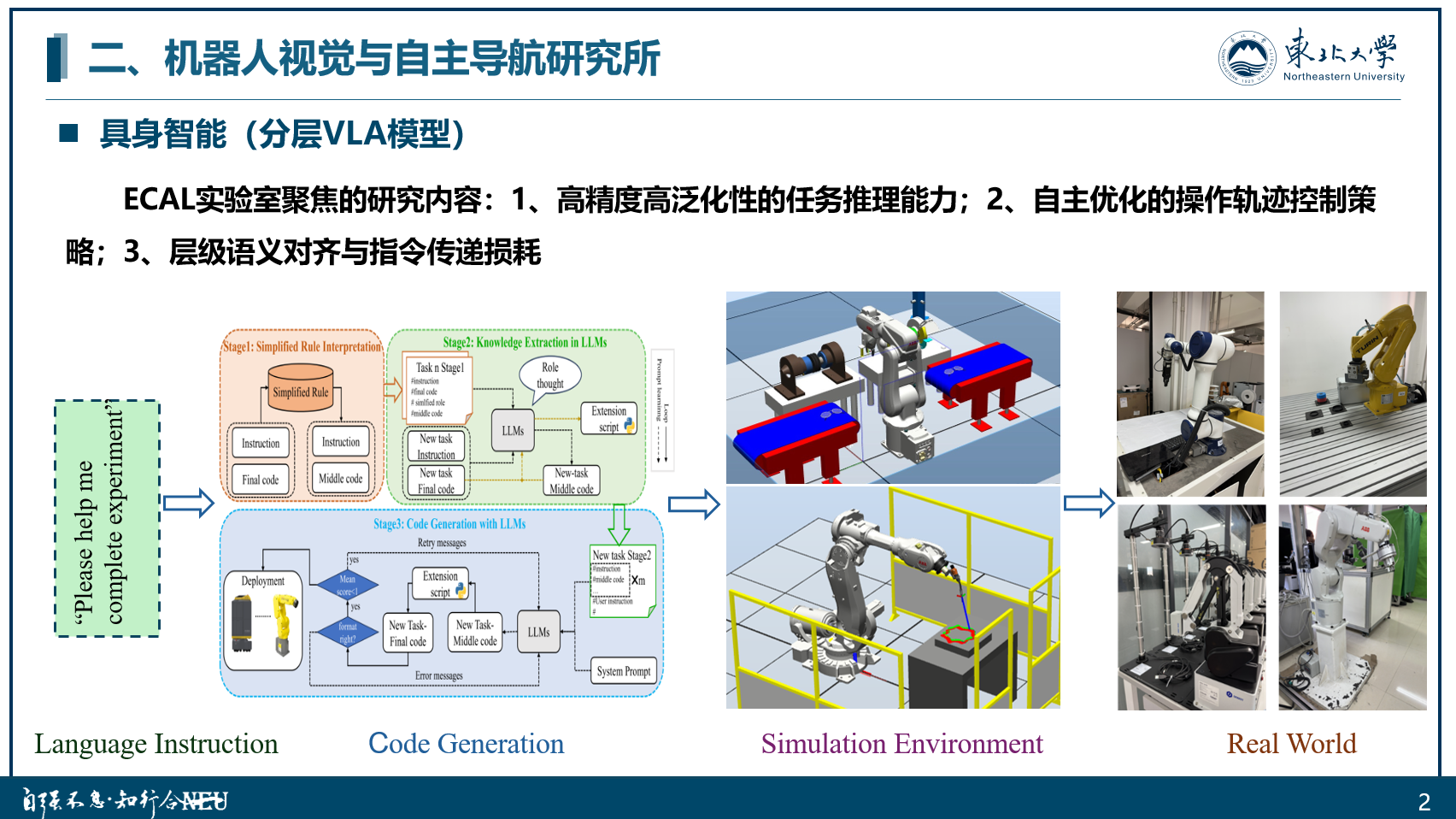

具身智能

端到端VLA模型,一种融合视觉感知、语言理解与动作生成的多模态大模型架构,直接将原始视觉输入、语言指令和环境状态映射为物理世界可执行的动作序列,实现从 “感知 - 推理 - 决策” 的全流程闭环。其核心优势在于端到端的统一建模,摒弃了传统模块化系统的信息割裂,通过跨模态注意力机制深度融合视觉特征、语言意图推理和动作约束控制,从而具备类人级场景推理能力。

分层VLA模型,是一种基于多模态大模型的层级化系统,其核心架构由任务逻辑推理中心(主 LLM)与协作式子模型(辅助 LLM 集群)构成,通过分工协同实现复杂任务的高效执行。主 LLM 作为决策中枢,负责解析自然语言指令、构建全局任务规划,并通过跨模态注意力机制融合视觉算法和机械臂运动学模型,生成粗粒度操作意图。辅助 LLM 集群配合主 LLM 将复杂任务拆解为子任务链,结合视觉信息实时推理环境动态(如遮挡、物理约束)并生成修正指令;同时通过自我评估优化控制参数,衔接高层决策与底层执行,增强系统在复杂场景中的适应性与精度。

长序列任务的VLA模型,其核心架构以主 LLM 为全局任务中枢,基于实验规程解析长序列逻辑,通过符号推理生成跨小时级的任务时序图谱;辅助 LLM 集群则拆解子任务链,结合视觉算法监测重复操作的一致性,并通过自我审核机制修正偏差。底层采用端到端VLA控制器,将高层指令转化为机械臂连续动作流,通过扩散模型优化重复操作的精度稳定性。该方案既通过端到端建模保证连续动作的流畅性,又借助分层 LLM 的逻辑调控应对长序列中的动态变化,即保障了任务进行的流畅度,也保证了相关操作的规范性约束。

多模态大模型

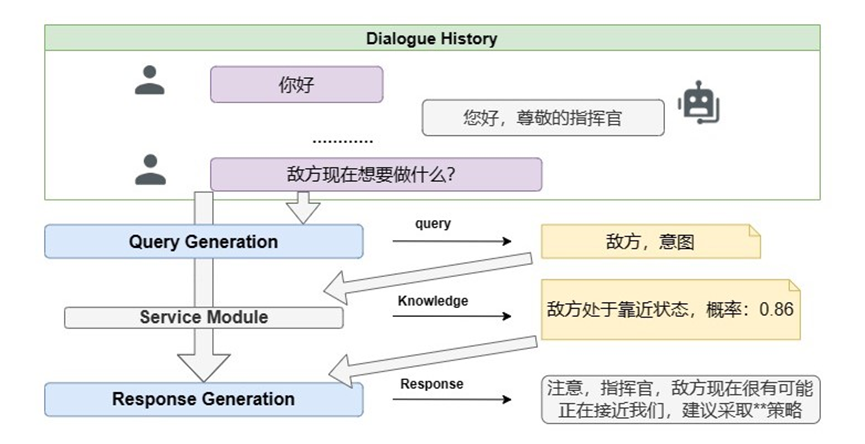

人机对话导航(Human-Machine Conversation) 是指让机器理解和运用自然语言实现人机通信的技术。 用户可以通过聊天机器人查询信息、获取特定知识库等。 人机对话可以分为面向任务的对话和开放域对话两种类型。本项目拟在战场场景下构建一个基于知识库的对话系统。 以往的面向任务的对话系统常通过构建静态知识库来获取特定的知识, 然而,在一些场景下,外部世界通常包含动态知识和时空状态, 因此,以前这些不包含时空状态和动态知识的方法限制了对话系统与人类的相似性。 在本项目中,我们将知识库信息作为对话系统连接世界的一种方式。 系统根据对话上下文和时空状态生成一个查询,通过查询来获取知识库信息, 这些知识库信息作为一个额外的知识使对话系统做出更加专业和自然的回答。

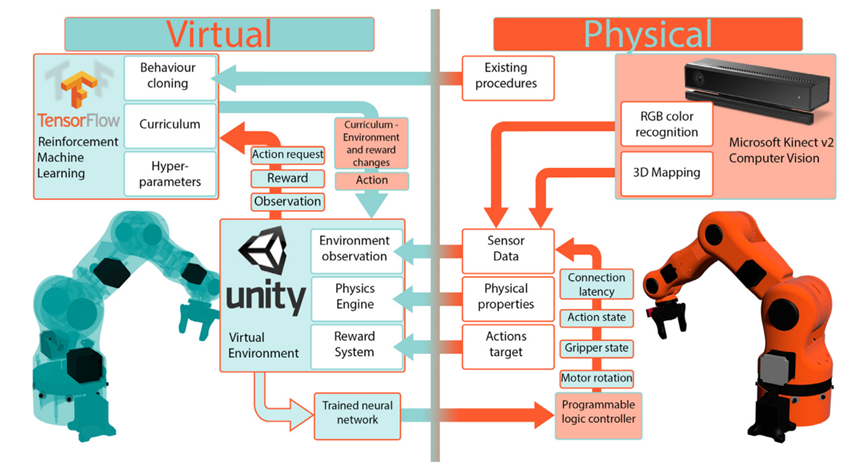

数字孪生

数字孪生是指针对物理世界中的物体,通过数字化的手段构建一个在数字世界中一模一样的实体, 借此来实现对物理实体的了解、 分析和优化。 从技术角度而言, 数字孪生集成了建模与仿真、虚拟现实、物联网、云边协同以及人工智能等技术,通过实测、仿真和数据分析来实时感知、诊断、预测物理实体对象的状态, 通过指令来调控物理实体对象的行为,通过相关数字模型间的相互学习来进化自身,合理有效地调度资源或对相关设备进行维护。 本实验室将数字孪生与机器人研究融合,探索针对机器人应用场景的三维重建,数据采集与传输,动力学仿真等问题, 将深度学习的研究成果部署到机器人数字孪生系统,赋予机器人认知及思考的能力,从而探索机器人更多有趣的应用场景。